浅谈AI甜品显卡和上限

2026 AI 甜品卡首选

选择一款显卡,首先要明确自己的需求,才知道该买什么级别的显卡。今天推荐一款AI甜品级显卡和该显卡能使用的模型。

刚过完2025,来到2026年,内存价格依然居高不下,消费级显卡因AI产能被挤占和内存成本增加,开始启动涨价潮。如果是土豪,请忽略以下内容,直接选目前消费级最强显卡:RTX 5090 32G 。如果是预算有限的AI爱好者或者研究人员,想要本地部署,那么推荐:RTX 5060Ti 16G 。

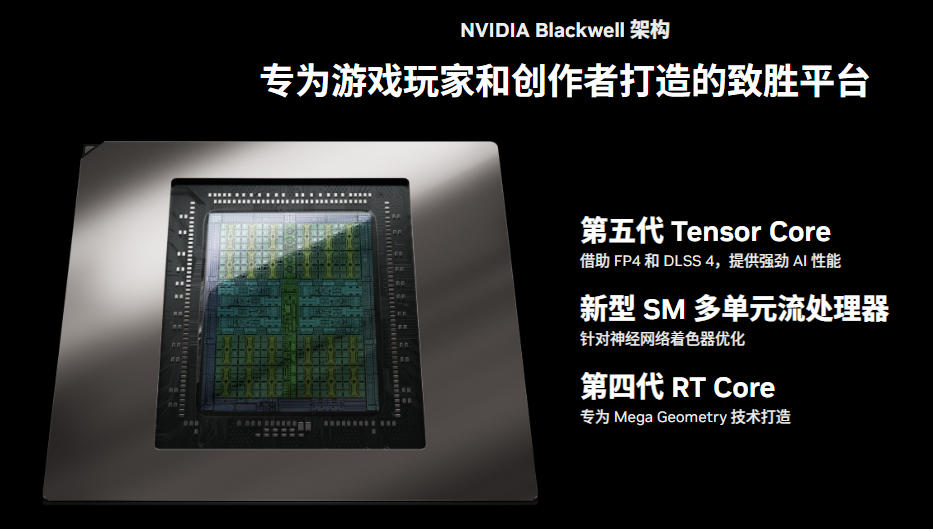

RTX 5060Ti 16G 是Blackwell架构下的“AI性价比之王”,16GB GDDR7 显存带宽大幅提升,比前代快30%以上。全新架构,对本地AI模型有加成,功耗约180W。N卡的CUDA架构不用多说,全球 90% 以上的 AI 研究人员和开发者都在使用基于 CUDA 开发的工具。

在这里不得不说老黄刀法精准,RTX 5070 12G,显存用于AI只能跑70亿~80亿参数,如果跑14b或16b,会将一部分模型装载到内存。频繁和内存交换数据结果就是,不如5060Ti 16G全部加载到内存中的速度。RTX 5070Ti 16G 价格是 5060Ti 16G 的两倍了。选择显卡还需要注意电源,如果是 RTX 5090 显卡,电源要1000W以上。

RTX 5060Ti 16G 的上限

如果是全量模型,可以跑160亿参数量的密集模型,如:qwen3:14b 、deepseek-r1:14b 。如果是混合专家模型,最多能跑300亿参数,如:qwen3-coder:30b 。超过这些参数量,部分模型会加载到内存,但速度就大打拆扣了。

根据模型类型,区分是密集型还是MoE混合型,参照以上标准即可。国外模型很多在中文理解能力和推理表现不如国产模型,也有经过中文优化的如:gemma3 。

RTX 5060Ti 16G 可以运行comfyui文生图,图像编辑。最近非常火的 Z-Image,8G显存都能跑,出图非常快。跑 Qwen-Image 和 Qwen-Image-Edit 的量化模型也没问题。如果用 Wan2.2 生成视频,帧率和分辨率都需要选低的,5秒以内,否则很容易OOM,即使内存够,也基本不可用。

本地VS云端

虽然本地模型和云端模型相比,参数量要少很多,但本地部署有一些无法替代的优化:

私有化,确保数据隐私和安全

模型功能不受限制,无审核

离线可用,成本低

虽然云端模型大而全,价格看上去很美丽。真正付过费的用户才知道有时候一个回答的tokens要花几块钱。本地模型不仅可以胜任一般工作,也可以通过它提取关键字或优化提示词,再跑云端模型,不仅更高效,还能节省不少tokens。

目前我用本地模型主要工作是:翻译,文生图,图像编辑(去除人物),去除用豆包或千问生成图的水映等。

如果你是AI爱好者或研究人员,想本地部署但并不明确自己的需求时,RTX 5060Ti 16G 绝对是最有性价比的AI甜品显卡。